Sujets 2012 - 2013

La liste de tous les sujets proposés dans un seul fichier en format pdf.

La liste de tous les sujets proposés dans un seul fichier en format pdf.

Encadrant : M. Mohamad Assaad

Email : mohamad.assaad at supelec.fr

N° du Sujet: RMS1_ETN

Présentation

Internet est un réseau décentralisé où le trafic est transmis d’un nœud (e.g serveur) à l’autre par un algorithme de routage jusqu’à la destination. Le contrôle de flux est indispensable dans ce type de réseaux afin de limiter la perte des paquets et les congestions au niveau des nœuds intermédiaires. Plusieurs techniques de contrôle de flux sont utilisées dans Internet aujourd’hui. Certains contrôleurs sont similaires aux techniques utilisées dans les systèmes automatiques de contrôle et d’asservissement. Ce projet a pour objectif de simuler un exemple simple d’un réseau formé de 3 à 4 nœuds. Il faut ensuite étudier et implémenter sous Matlab un contrôleur de flux internet et mesurer la densité de trafic et le niveau de congestion dans le réseau.

Domaines concernés:

Réseau internet, contrôle linéaire

Moyens mis en œuvre:

Logiciel à utiliser : Matlab

Encadrant : M. Mohamad Assaad

Email : mohamad.assaad at supelec.fr

N° du Sujet: RMS2_ETN

Présentation

Les systèmes futurs de communications mobiles sont appelés à fournir la capacité d’accès suffisante à un nombre croissant d’utilisateurs combiné à une densification du trafic mixte « Internet mobile, services temps réel ». Dans ce contexte, de nouveaux systèmes ont été développés, implémentés ou en cours de normalisation (e.g. WiMAX, 4G, etc.).

Plusieurs techniques ont été introduites dans ces systèmes pour permettre de transmettre des services «à haut débit ». Au niveau de l’interface radio, il s’agit plus particulièrement de définir un système capable de supporter des transmissions sur différentes largeurs de bande, de 1.25 MHz jusqu’à 20 MHz pour rentabiliser l’occupation spectrale et augmenter les débits utilisateurs. Il s’agit aussi d’introduire de nouveaux schémas de transmission et des technologies avancées utilisant plusieurs antennes d’émission et de réception pour augmenter l’efficacité spectrale.

Plusieurs stratégies d’allocation de ressources peuvent être envisagées pour la gestion des flux vidéo dans les réseaux futurs. L’objectif est de maximiser le débit moyen de l’ensemble des utilisateurs tout en assurant une équité entre les utilisateurs afin de répondre aux besoins de chaque utilisateur en termes de débit et délai (QoS). L’objectif de ce projet est de développer/simuler une approche avancée de gestion des flux vidéo dans un réseau cellulaire de nouvelle génération.

Domaines concernés:

Réseau sans fil, flux vidéo, contrôle linéaire

Moyens mis en œuvre:

Logiciel à utiliser : Matlab

Encadrant : Mme Jocelyne ELIAS

Email : jocelyne.elias at parisdescartes.fr

N° du Sujet: RMS3

Présentation

Objectif : le but de ce projet est de maîtriser l’utilisation du logiciel d’optimisation CPLEX Optimization Studio. En premier temps, l’étudiant doit installer le logiciel et le faire fonctionner. Après, il va apprendre à l’utiliser en prenant des exemples simples. Enfin, il va réaliser un exemple sur les réseaux, obtenir et commenter les résultats obtenus.

Description : le travail consiste donc à réaliser les tâches suivantes :

Références

[1] CPLEX Optimization Studio, http://www-01.ibm.com/software/websphere/products/optimization/academic-initiative/

[2] IBM ILOG CPLEX Optimization Studio Preview Edition Trial,

http://www-01.ibm.com/software/websphere/products/optimization/cplex-studio-preview-edition/

[3] J. ELIAS, A. Mehaoua, Energy-aware Topology Design for Wireless Body Area Networks, In Proceedings of IEEE International Conference on Communications, ICC 2012, Ottawa, Canada, June 2012.

[3] Ehyaie, M. Hashemi, and P. Khadivi. Using relay network to increase life time in wireless body area sensor networks. In Proc. Of the 10th IEEE International Symposium on a World of Wireless, Mobile and Multimedia Networks & Workshops (WoWMoM), pages 1–6, Kos, Greece, June, 2009.

[3] E. Reusens, W. Joseph, B. Latré, B. Braem, G. Vermeeren, E. Tanghe, L. Martens, I. Moerman, and C. Blondia. Characterization of on-body communication channel and energy efficient topology design for wireless body area networks. IEEE Transactions on Information Technology in Biomedicine, 13(6):933–945, September 29, 2009.

Encadrant : Mme Jocelyne ELIAS

Email : jocelyne.elias at parisdescartes.fr

N° du Sujet: RMS4

Présentation

Objectif : Ce projet a pour but de faire une étude bibliographique et comparative entre des modules sans fil, de technologies différentes (TelosB, MicaZ, Shimmer, …), dédiés pour les réseaux de capteurs sans fil à basse puissance. Ces modules peuvent être utilisés pour des tâches particulières ; par exemple, pour relever la position, suivre le mouvement d’une personne, mesurer certains signaux vitaux …

|

|

|

|

|

|

Description : le travail consiste donc à réaliser les tâches suivantes :

Références

[1] Shimmer, http://www.shimmer-research.com/p/products/development-kits/lab-development-kit-mini

[2] MEMSIC, http://www.memsic.com/products/wireless-sensor-networks/wireless-modules.html

[3] Crossbow, http://bullseye.xbow.com:81/Products/productdetails.aspx?sid=164

[4] MicaZ (Crossbow) datasheet, http://www.openautomation.net/uploadsproductos/micaz_datasheet.pdf

[5] TelosB (Crossbow) datasheet, http://www.willow.co.uk/TelosB_Datasheet.pdf

[6] Ullah, S. and Higgins, H. and Braem, B. and Latre, B. and Blondia, C. and Moerman, I. and Saleem, S. and Rahman, Z. and Kwak, K.S., A comprehensive survey of wireless body area networks, Journal of medical systems, vol. 36, no. 3, pages 1065-1094, 2012.

Encadrant : Mme Jocelyne ELIAS

Email : jocelyne.elias at parisdescartes.fr

N° du Sujet: RMS3

Présentation

Le but de ce projet est d’étudier le problème de planification des réseaux "verts" (réseaux à basse consommation d’énergie), en utilisant des concepts de la Théorie des Jeux (l’équilibre de Nash, Nash Bargaining Solution, jeux (non)-coopératifs, etc.).

De nouveaux algorithmes complètement distribués ont besoin d’être mis en œuvre pour la gestion efficace des réseaux "verts" distribués à large échelle.

Le travail consiste à étudier le problème de planification des réseaux "verts" d’une manière complètement distribuée, en utilisant la Théorie des Jeux, et se compose des étapes suivantes :

Références

[1] L. Chiaraviglio, M. Mellia, and F. Neri. Energy-aware Backbone Networks: a Case Study<. In GreenComm, 2009.

[2] L. Chiaraviglio, M. Mellia, and F. Neri.Reducing Power Consumption in Backbone Networks. In ICC, 2009.

[3] J. Chabarek, J. Sommers, P. Barford, C. Estan, D. Tsiang, and S.Wright. Power awareness in network design and routing. In IEEE INFOCOM 2008.

[4] E. Altman, T. Boulogne, R. El-Azouzi, T. Jimenez, L. Wynter, A survey on networking games in telecommunications, Elsevier Computers and Operations Research, 33(2): 286-311, 2006.

[5] J. ELIAS, F. Martignon, K. Avrachenkov, G. Neglia, Socially-Aware Network Design Games, in Proceedings of the 29th IEEE Conference on Computer Communications (INFOCOM 2010), March 2010, San Diego, CA, USA.

Encadrant : M. Osman SALEM

Email : osman.salem at parisdescartes.fr

N° du Sujet: RMS4

Présentation

L’objectif de ce projet est de développer une méthode online pour la détection et la suppression des données extrêmes (outliers) dans le trafic des réseaux de capteurs médicaux. Ces valeurs tendent à biaiser les statistiques différentielles (ANOVA, tests t, régression multiple, etc.).

Dans ce projet, vous commencez avec une étude sur les méthodes existantes pour la détection et suppression de valeurs extrêmes. Ensuite, vous choisissez la meilleure méthode, et vous développez cette méthode, pour l’appliquer ensuite sur les traces de trafic réel extrait du réseau de capteurs sans fils. Ces traces seront fournies par l’encadrant.

Des compétences en C et en WiseML (schéma XML) sont requises.

Encadrant : M. Hassine MOUNGLA

Email : hassine.moungla at parisdescartes.fr

N° du Sujet: RMS5

Présentation

Les progrès déjà réalisés et ceux qui sont en cours dans le domaine biomédical et celui des

communications permettent d'envisager le monitoring d'une personne au cours de ses activités. Il est nécessaire pour cela de placer sur le corps divers capteurs, permettant d'effectuer des mesures en temps réel, puis de les transmettre à distance ou de les stocker pour analyse ultérieure. Toutefois la mise en œuvre concrète d'un tel monitoring pose de nombreux problèmes liés au positionnement des capteurs, à l'énergie dont ils ont besoin, et à l'échange des données entre les capteurs et avec le système de stockage ou de transmission. Ces problèmes requièrent des solutions différentes, encore très embryonnaires, selon l'application visée (monitoring à but médical, sportif, professionnel, …).

Dans ce contexte, le travail porte sur le positionnement d’un ensemble de capteur sur le corps humain. Notre système évalue des requêtes continues sur des flux de données issues de capteurs dans un but de surveillance médicale. Afin de prolonger la durée de fonctionnement du système, il est crucial de prolonger la durée de vie des capteurs utilisés. Pour économiser leur énergie, nous nous intéressons à la mise en place d’une méthode de distribution des capteurs sur un corps humain telles que la position du capteur soit optimale quant à la consommation d’énergie (réduction de la puissance du signale utilisé) sans que la qualité du monitoring ne soit affectée.

Les étudiants travailleront sur la mise en place d’une méthode de positionnement des capteurs dans un environnement 3D afin de minimiser l’énergie drainée par le réseau de capteur.

Encadrant : M. Hassine MOUNGLA

Email : hassine.moungla at parisdescartes.fr

N° du Sujet: RMS6

Présentation

Les progrès déjà réalisés et ceux qui sont en cours dans le domaine biomédical et celui des communications permettent d'envisager le monitoring d'une personne au cours de ses activités. Il est nécessaire pour cela de placer sur le corps divers capteurs, permettant d'effectuer des mesures en temps réel, puis de les transmettre à distance ou de les stocker pour analyse ultérieure. Toutefois la mise en œuvre concrète d'un tel monitoring pose de nombreux problèmes liés au positionnement des capteurs, à l'énergie dont ils ont besoin, et à l'échange des données entre les capteurs et avec le système de stockage ou de transmission. Ces problèmes requièrent des solutions différentes, encore très embryonnaires, selon l'application visée (monitoring à but médical, sportif, professionnel, …).

Dans ce contexte, le travail porte sur l'économie d'énergie des capteurs. Notre système évalue des requêtes continues sur des flux de données issues de capteurs dans un but de surveillance médicale. Afin de prolonger la durée de fonctionnement du système, il est crucial de prolonger la durée de vie des capteurs utilisés. Pour économiser leur énergie, nous nous intéressons à des stratégies de mise en veille des capteurs telles que la qualité du monitoring ne soit pas affectée.

Les étudiants travailleront sur l'exécution d'un type de requêtes combiné à certaines stratégies de mise en veille des capteurs dans le but de mesurer et améliorer le gain énergétique.

Encadrant : M. Hassine MOUNGLA

Email : hassine.moungla at parisdescartes.fr

N° du Sujet: RMS7

Présentation

De nombreuses applications de réseaux de capteurs sans fils voient actuellement le jour, dans des domaines aussi variés que la Défense, la sécurité, la santé ou les maisons intelligentes. Leur but est souvent de surveiller de remonter une alarme en cas de détection d’un évènement redouté. Lorsqu’un tel événement se produit, l’application doit réagir au plus tard après un temps connu et borné ; il s’agit de contraintes dites temps-réel dur. Or dans la littérature peu de protocoles de communication pour les réseaux de capteurs permettent de respecter ce type de contraintes, et à notre connaissance, le seul existant fait des suppositions très contraignantes sur le réseau de capteurs.

Ces travaux ont donné lieu à la soumission d’un article de recherche au « 13th Annual Meeting of the IEEE International Symposium on Modeling, Analysis and Simulation of Computer and Telecommunication Systems (MASCOTS’05) », qui aura lieu à Atlanta aux Etats-Unis, du 26 au 29 septembre 2005.

Dans ce travail, nous avons choisi de prendre comme exemple une application de surveillance médicale qui remonte des alarmes médicale suite à un problème grave de santé, le réseau étant linéaire, le routage devient inutile. Le travail demandé et de proposer donc un nouveau protocole MAC temps-réel en faisant des hypothèses réalistes sur les réseaux de capteurs médicaux.

Encadrant : M. Hassine MOUNGLA

Email : hassine.moungla at parisdescartes.fr

N° du Sujet: RMS8

Présentation

De nombreuses applications de réseaux de capteurs sans fils voient actuellement le jour, dans des domaines aussi variés que la Défense, la sécurité, la santé ou les maisons intelligentes. Leur but est souvent de surveiller de remonter une alarme en cas de détection d’un évènement redouté. Lorsqu’un tel événement se produit, l’application doit réagir au plus tard après un temps connu et borné ; il s’agit de contraintes dites temps-réel dur. Or dans la littérature peu de protocoles de communication pour les réseaux de capteurs permettent de respecter ce type de contraintes, et à notre connaissance, le seul existant fait des suppositions très contraignantes sur le réseau de capteurs.

Ces travaux ont donné lieu à la soumission d’un article de recherche au « 13th Annual Meeting of the IEEE International Symposium on Modeling, Analysis and Simulation of Computer and Telecommunication Systems (MASCOTS’05) », qui aura lieu à Atlanta aux Etats-Unis, du 26 au 29 septembre 2005.

Les réseaux de capteurs constituent un domaine de recherche en développement très rapide. Les recherches sur ce sujet proviennent de la prise de conscience qu’il est possible de réaliser des dispositifs de très petite taille pouvant être mis à profit pour des applications très diverses : surveillance de l’environnement, santé, étude des comportements, habitat intelligent, etc.

Afin d’optimiser la durée de vie du réseau, il faut répartir au mieux l’énergie dépensée par les capteurs pour les différentes transmissions d’information, ce qui explique le développement de nombreuses approches coopératives. La problématique des nœuds relais et l'extension inévitable au 'routage' multi-saut, et les techniques de partage des ressources sont autant d'axes de recherche qui doivent tirer partie des connaissances en traitement du signal et en communications numériques.

Références

[1] S. Cui, A. J. Goldsmith, and A. Bahai, "Energy-efficiency of MIMO and cooperative MIMO techniques in sensor networks", IEEE Jour. On Selected Areas in Communications, vol. 22, no. 6, pp. 1089 – 1098, August 2004.

[2] T. Nguyen, O. Berder, and O. Sentieys, "Cooperative MIMO schemes optimal selection for wireless sensor networks", IEEE 65th Vehicular Technology Conference, VTC-Spring, pp. 85 – 89, 2007.

[3] R.Pabst et al, "Relay-based deployment concepts for wireless and mobile broadband radio", IEEE Communications magazine, Vol. 42, n° 9, pp. 80 – 89, Sept. 2004.

[4] T. Nguyen, O. Berder, and O. Sentieys, "Impact of transmission synchronization error and cooperative reception techniques on the performance of cooperative MIMO systems", Proceedings of ICC 2008, Beijing, China, pp. 4601 – 4605, May 2008.

Encadrant : M. Laurent Wendling

Email : laurent.wendling at parisdescartes.fr

N° du Sujet: SIP1

Présentation

Savoir évaluer le positionnement spatial entre régions bidimensionnelles est fondamental dans de nombreux systèmes d’analyse et d’interprétation d’images. Notre équipe travaille, dans le cadre d’un projet ANR, sur des modèles prédictifs pour analyser des pathologies en fonction de séries d’images médicales pré-segmentées (c’est à dire que les régions ont déjà été extraites de l’image).

L’objectif de ce stage est d’étudier, et d’implémenter, une modélisation robuste de relations spatiales directionnelles (« à gauche de », « à droite de », « au dessus de », « en dessous de ») fondée sur la notion de paysages flous. Cette approche permet d’estimer rapidement le positionnement relatif entre régions et peut s’étendre aisément à d’autres directions que les quatre classiques et aussi à des régions à niveaux de gris.

Une comparaison pourra ensuite être réalisée à partir des modèles développés dans notre équipe.

Compétences requises

La programmation se fera en C/C++ ou Java.

Encadrant : M. Laurent Wendling

Email : laurent.wendling at parisdescartes.fr

N° du Sujet: SIP2

Présentation

La segmentation est souvent la première étape d’un système de reconnaissance des formes. La qualité de ce traitement est importante car il conditionne la précision des traitements ultérieurs. De ce fait, la plupart des modèles se fondent sur des seuils fixés à la main. Ces derniers sont difficilement transposables lorsque les conditions d’acquisition changent et sont fortement dépendants du contenu des images. Il est donc important d’avoir des modèles robustes, et automatiques, permettant de trouver les régions contenues dans les images.

L’objectif de ce stage est d’étudier, et d’implémenter, une segmentation d’images médicales à partir d’un critère d’entropie floue. Dans un premier temps le traitement se focalisera sur une phase de binarisation en considérant deux régions (le fond et la forme), puis nous étudierons comment étendre cette approche à un nombre quelconque de régions.

Compétences requises

La programmation se fera en C/C++ ou Java.

Encadrant : Mme Nicole VINCENT

Email : nicole.vincent at mi.parisdescartes.fr

N° du Sujet: SIP3

Présentation

Si l’humain lit indifféremment un texte imprimé ou manuscrit, il n’en est pas de même des ordinateurs, dans lesquels les logiciels de reconnaissance de caractères (OCR) sont adaptés aux documents imprimés. Pour les documents manuscrits ou mixtes la stratégie doit être adaptée au type du contenu, la première étape est donc de déterminer si un bloc contient du manuscrit ou de l’imprimé. Objectif de ce projet est de réaliser cette étape.

Les méthodes développées consistent à calculer des caractéristiques associées à un bloc et à utiliser un classificateur. En effet un texte manuscrit est moins régulier qu’un texte imprimé, régularité de la ligne de base, régularité de l’épaisseur du trait, ….

Le travail comporte plusieurs étapes :

Encadrant : Mme Nicole VINCENT

Email : nicole.vincent at mi.parisdescartes.fr

N° du Sujet: SIP4

Présentation

La sécurité des documents est un problème qui prend de plus en plus d’importance lors des transferts de documents électroniques. Pour cela une phase de tatouage peut être envisagée. L’objectif du projet est d’une part de construire un document tatoué à partir d’un quelconque document textuel imprimé et de savoir reconnaître si un document électronique a été tatoué ou non. Evidemment le tatouage ne doit pas être visible.

La méthode de tatouage proposée est de remplacer toutes les occurrences de la lettre « e » par une lettre « e » ayant un caractère particulier. Par exemple, la barre du e peut être horizontale et comporter un pixel isolé juste au-dessus. Ce pixel ne sera pas visible.

Le travail comporte plusieurs étapes :

Le tatouage d’image :

- Rechercher les « e » en utilisant éventuellement un logiciel d’OCR.

- Modifier la forme du « e ».

L’authentification d’un document tatoué :

- Rechercher les « e »

- Tester la forme des « e »

- Décider de l’authenticité du document

Evaluation de la robustesse de la méthode :

- Faire subir à l’image tatouée des transformations comme un changement d’échelle, une compression / décompression

- Vérifier l’authentification

Encadrant : Mme Nicole VINCENT

Email : nicole.vincent at mi.parisdescartes.fr

N° du Sujet: SIP5

Présentation

Les appareils photos des téléphones portables sont de qualité de plus en plus grande, mais les images manquent encore de précision et de netteté quand on veut prendre l’image d’un objet particulier. Nous envisageons ici des documents comme du texte écrit sur une feuille ou sur un tableau, une pièce d’identité. Les applications sont nombreuses, la reconnaissance du texte, l’identification de la photo sur la pièce d’identité pour n’en citer que deux. On cherche à améliorer l’image en vue des traitements ultérieurs par l’acquisition d’une séquence d’images. Les images sont presque identiques mais ont des points de vue un peu différents. A partir de la fusion de plusieurs images, une nouvelle image doit être construite.

Pour cela il est nécessaire de recaler les images avant de procéder à la fusion.

Le travail comporte plusieurs étapes, à partir d’une suite d’images :

- Pour chaque image, réaliser une interpolation pour atteindre une résolution subpixellique.

- Pour chaque image sur-résolue, détecter des points d’intérêt.

- Apparier les points d’intérêt sur deux images consécutives.

- En déduire un recalage entre une image et la précédente.

- Fusionner les images.

- Revenir à une image de taille initiale.

- Comparer cette image avec une des images initiales.

Encadrant : M. Mehdi Bentounsi

Email : mehdi.bentounsi at parisdescartes.fr

N° du Sujet: GFD1

Présentation

De nos jours, les systèmes d’identifications basés sur des données biométriques permettent une authentification des individus avec une garantit suffisante. Néanmoins, le besoin énorme en ressources informatiques "calcul et stockage" de ces systèmes freine considérablement leurs utilisations à grande échelle.

Le cloud computing offre la possibilité d’externaliser à la fois le calcul et le stockage des données biométriques à moindre cout. Aussi, son élasticité permet de répondre aux pics des demandes d’authentifications aux heures de pointes. Cependant, des problèmes de sécurité et de confidentialité des données biométriques manipulées peuvent se poser, et par conséquent doivent être traité afin de convaincre les institutions à externaliser leurs systèmes d’identifications chez des providers de cloud computing. Une solution serait d’utiliser des protocoles d’externalisations sures et qui vérifient en même temps l’exactitude des résultats retournés.

[Atallah et al, 2005] ont proposé un protocole léger ‘coté client’ pour une externalisation (sur un serveur distant) de la comparaison des données biométriques sans révéler des informations qui faciliteraient une usurpation d’identité par des attaqueurs. Le protocole est léger car il utilise une cryptographie simple basé sur les tables de hachage. La comparaison des données biométriques (empreintes digitales) utilisent les distances de Hamming.

On considère que ce protocole peut être une base pour un service d’authentification sécurisé utilisant une plateforme cloud computing.

Travail demandé :

Les objectifs du stage sont :

Références

[1] L. Chiaraviglio, M. Mellia, and F. Neri. Energy-aware Backbone Networks: a Case Study>. In GreenComm, 2009.

[2] L. Chiaraviglio, M. Mellia, and F. Neri. Reducing Power Consumption in Backbone Networks. In ICC, 2009.

Encadrant : M. Mehdi Bentounsi

Email : mehdi.bentounsi at parisdescartes.fr

N° du Sujet: GFD2

Présentation

BPaaS pour « business process as a service » est considéré comme la prochaine grande révolution dans le monde de l’informatique. En effet, à l’horizon 2015, 50% des processus métiers d’entreprises seront externalisé vers des plateformes cloud computing sous la forme de BPaaS. Une des caractéristiques du cloud computing est la multi-tenancy. La multi-tenancy est le fait que plusieurs clients/tenants utilisent simultanément une seule plateforme. Cette caractéristique permet la réutilisation de parties de processus métiers, appelés « fragments », entre les tenants pour la construction de nouveaux processus à moindre couts. Cette réutilisation pose des problèmes de préservation de l’intimité des tenants dans le cloud.

Dans la littérature, plusieurs techniques existent pour préserver l’intimité d’un individu. Une intimité peut être définit de plusieurs manières. Elle peut être un ensemble de données personnelles, comme par exemple : une date de naissance ou bien une adresse postale ; Comme elle peut être une activité, par exemple : faire ses courses chaque Samedi chez un commerçant donné. Ces techniques vont du a) cryptage de la donnée, b) à son partage puis distribution entre plusieurs nœuds évitant ainsi qu’elle se retrouve en totalité sur un seul nœud qui pourra la lire, en passant par c) l’anonymisation qui nous cache la provenance d’une donnée, par exemple : on aura une date de naissance en claire mais on n’arrivera pas à faire un lien avec un nom/prénom pour reconnaitre la personne concernée.

[Bentounsi et al] ont proposé un service d’anonymisation des fragments de processus métiers pour permettre une réutilisation sure et sans risque de ces fragments par l’ensemble des tenants du cloud computing. L’anonymisation cache la provenance d’un fragment lors de la construction d’un nouveau processus métier, ce qui veut dire qu’un tenant va réutiliser un fragment pour construire son processus métier sans découvrir l’appartenance ce fragment.

Travail demandé :

Les objectifs du stage sont :

Références

[Bentounsi et al]. Mehdi Bentounsi, Salima Benbernou and Mikhail J. Atallah: Privacy-Preserving Business Process Outsourcing. Submitted to CAISE 2012.

Encadrant : M. François-Xavier Jollois

Email : fxjolloisupd at gmail.com

N° du Sujet: GFD3

Présentation

Dans ce projet, il s'agira de programmer sur le logiciel R une méthode de classification applicable sur des données ordinales et de comparer les résultats sur différents jeux de données. Une formation sur l'utilisation du logiciel sera dispensée si nécessaire.

Encadrant : M. François-Xavier Jollois

Email : fxjolloisupd at gmail.com

N° du Sujet: GFD4

Présentation

Dans ce projet, il s'agira d'adapter sur le logiciel R une méthode existante, CART, en lui ajoutant une notion d'incertain (décision impossible) et d'appliquer celle-ci sur des données réelles concernant des accidents cardiaques. Une formation sur l'utilisation du logiciel sera dispensée si nécessaire.

Encadrant : M. Blaise HANCZAR

Email : blaise.hanczar at parisdescartes.fr

N° du Sujet: GFD5

Présentation

Les puces à ADN (ou biopuces) permettent de mesurer l'expression de plusieurs milliers de gènes simultanément à travers différentes conditions expérimentales. Ce type de données permet de détecter la présence de certaine maladie, en particulier les cancers, et seront à la base des futurs systèmes de diagnostiques. Le problème est que le signal de la maladie est généralement noyé dans l'expression des milliers de gènes que comporte le génome humain. Pour cela on utilise des algorithmes d'apprentissage automatique qui vont "apprendre" le signal de la maladie à partir d'un jeu de données d'exemples. Une fois l'apprentissage effectué, le modèle obtenu va pouvoir faire des diagnostiques sur des patients. L'objectif étant d'obtenir les modèles les plus précis possible.

Le travail consistera à développer un système de prédiction en utilisant les méthodes de boosting. Le boosting consiste a combiner plusieurs classeurs en portant une attention particulière aux points difficiles. L’objectif des étudiants sera de comprendre le modèle de boosting, de l’implémenter et de l’utiliser sur des jeux de données réels.

Encadrant : M. Blaise HANCZAR

Email : blaise.hanczar at parisdescartes.fr

N° du Sujet: GFD6

Présentation

Les puces à ADN (ou biopuces) permettent de mesurer l'expression de plusieurs milliers de gènes simultanément à travers différentes conditions expérimentales. L'une des principales approches d'analyse sont les méthodes de classification qui consistent à regrouper les gènes ayant un comportement similaire sur l'ensemble des conditions expérimentales. L'hypothèse généralement admise est que des gènes ayant un profil d'expression proche, ont des fonctions biologiques proches.

Le but de ce travail sera de développer la méthode de co-clustering de Cheng & Church pour analyser les données biopuces. Cette approche est une méthode itérative qui permet de découvrir simultanément des groupes de gênes et conditions expérimentales ayant un profil proche. L’objectif des étudiants sera de comprendre cette méthode, de l‘implémenter et de l’utiliser sur des jeux de données réels.

Encadrant : Mme Nicoleta ROGOVSCHI et M. Nistor GROZAVU

Email : nicoleta.rogovschi at parisdescartes.fr,nistor at lipn.univ-paris13.fr

N° du Sujet: GFD7

Présentation

Le travail effectué dans ce projet se situe dans le domaine du data mining, plus précisément dans le cadre de prétraitement de données.

La normalisation de données représente une étape importante dans le processus de data mining durant la phase de prétraitement de données. La factorisation matricielle (décomposition) représente quand à elle, un rôle important dans l'amélioration des données avant de les présenter à une technique de clustering (de data mining). Un point commun pour la suppression du bruit, la réduction de dimensions est de remplacer les données d'origine par une représentation approximative réduite des dimensions obtenues via une matrice, ou une décomposition matricielle. Cette technique de décomposition peut être vue comme une normalisation (standardisation) de données qui a comme but l'amélioration de la qualité de données sans perdre de l'information.

Le but de ce stage est de mettre en œuvre plusieurs techniques de normalisation à base de transformation matricielle et de tester leurs impacts sur ces données en utilisant un algorithme de classification sur les données normalisées. Pour ce stage, les étudiants devront utiliser Matlab (et/ou C/C++ et/ou Java) comme langage de programmation pour leurs méthodes.

Encadrant : Mme Nicoleta ROGOVSCHI et M. Nistor GROZAVU

Email : nicoleta.rogovschi at parisdescartes.fr,nistor at lipn.univ-paris13.fr

N° du Sujet: GFD8

Présentation

Le clustering topologique permet à la fois une segmentation de données dans des clusters et la visualisation du résultat en utilisant la matrice de prototypes construite pendant le processus d'apprentissage. Une des techniques les plus utilisées pour répondre à ce problème sont les cartes auto-organisatrices (SOM : Self Organizing Maps) qui représentent un réseau de neurones artificiels à deux couches : une couche d'entrée et une couche topologique. Les poids de neurones sont initialisés d'une manière aléatoire ou en utilisant les vecteurs propres obtenu avec l'analyse en composante principales (ACP). En utilisant l'ACP, l'algorithme va converger plus vite. Donc, ce stage a comme but l'analyse de la combinaison de l'ACP et SOM pour obtenir une méthode hybride permettant de faire converger plus vite l'algorithme des cartes auto-organisatrices et de réduire le temps de calcul (d'apprentissage). Pour ce travail, les stagiaires pourront utiliser les toolboxes de SOM et Statistique de Matlab ou la plate-forme Open Source « Knime».

Encadrant : Mme Nicoleta ROGOVSCHI et M. Nistor GROZAVU

Email : nicoleta.rogovschi at parisdescartes.fr,nistor at lipn.univ-paris13.fr

N° du Sujet: GFD9

Présentation

Le clustering topologique permet à la fois une segmentation de données dans des clusters et la visualisation du résultat en utilisant la matrice de prototypes construite pendant le processus d'apprentissage. Le résultat de ce type d'approche est la répartition de données dans des micro-clusters tout en préservant la topologie de données (les données similaires dans l'espace de données seront similaire sur la carte topologique). Les cartes auto-organisatrices présentées par Kohonen ont été largement utilisées pour la classification et la visualisation des bases de données multidimensionnelles.

Ce modèle classique se présente sous forme d’une carte possédant un ordre topologique de cellules. Les cellules sont réparties sur les nœuds d’un maillage.

Dans ce stage on s'intéresse à la répartition de données à l'intérieur de chaque cellule de la carte. Pour répondre à ce problème, une des solutions est d'utiliser un arbre de décision pour chaque prototype. Un arbre de décision est un algorithme de classification permettant de construire une hiérarchie pour chaque groupe de données. Il s'agit d'étudier la répartition de données dans chaque cellule (neurone) de la carte en utilisant un arbre de décision sur l'ensemble de données captées par chaque cellule. Donc, le partitionnement de données (les cellules de la carte) sera décrit à l’aide d’un arbre de décision. Pour ce travail, les stagiaires pourront utiliser les toolboxes de SOM et Statistique de Matlab ou la plate-forme Open Source « Knime ».

Encadrant : Mme Nicoleta ROGOVSCHI et M. Nistor GROZAVU

Email : nicoleta.rogovschi at parisdescartes.fr,nistor at lipn.univ-paris13.fr

N° du Sujet: GFD10

Présentation

Le but de ce stage est de mettre en œuvre une technique de normalisation et de co-clustering pour l'environnement Knime. En général le clustering s’effectue soit sur l’ensemble des individus, soit sur l’ensemble des variables, ce qui privilégie d’une manière dissymétrique un des deux ensembles. De ce point de vue il sera intéressant de réaliser une partition simultanément sur les deux ensembles et dans ce cas on va utiliser des approches de bi-clustering ou co-clustering. Pour améliorer le résultat de co-clustering (surtout pour les grandes bases de données), une étape de prétraitement des données est nécessaire, comme par exemple l'utilisation de la décomposition en valeurs singuliers (SVD : Singular Value Decomposition) pour réduire la taille de description du jeu de données.

KNIME (Konstanz Information Miner) est un logiciel Open Source (http://www.knime.org/) pour l'intégration, le traitement, l'analyse et l'exploitation de données. La plate-forme Knime permet d'ajouter de nouveaux modules en utilisant du code Java.

Le but de ce stage est de programmer la SVD et l'adapter pour l'environnement Knime et mettre en place une technique de co-clustering en utilisant la SVD et k-means (ou les cartes auto-organisatrices déjà existant en Knime pour un co-clustering topologique).

La connaissance du langage Java est nécessaire pour ce projet.

Encadrant : Mme Soror SAHRI

Email : soror.sahri at parisdescartes.fr

N° du Sujet: GFD11

Présentation

Les dépendances fonctionnelles conditionnelles (CFDs) sont une extension des dépendances fonctionnelles. Elles ont été proposées pour vérifier la qualité des données stockées dans les bases de données [1]. Elles permettent.la détection de violation de contraintes dans les bases de données relationnelles, et ainsi le nettoyage des données (ang. data cleaning).

L’objectif du stage du master est l’application des CFDs sur une table distribuée. Pour cela, on utilisera l’algorithme «On-demand» proposé dans [2]. Dans un premier temps, l’algorithme sera appliqué sur une table globale, ensuite il faut l’appliquer sur les différentes partitions distribuées de cette table.

Références

[1] P. Bohannon, W. Fan, F. Geerts, X. Jia, and A. Kementsietsidis. Conditional functional dependencies for data cleaning. In ICDE, 2007.

[2] Lukasz Golab, Howard Karloff, Flip Korn, Divesh Srivastava, and Bei Yu. On generating near-optimal tableaux for conditional functional dependencies. In VLDB, 2008.

Encadrant : M. David JANISZEK

Email : david.janiszek at parisdescartes.fr

N° du Sujet: P1

Contexte de l’étude

Depuis quelques années, les processeurs graphiques (Graphics Processing Unit - GPU) sont utilisés pour réaliser des calculs scientifiques. En effet pour les traitements pouvant être parallélisés, les GPU sont 10 à 40 fois plus rapides que les processeurs centraux (Central Processing Unit - CPU). L'utilisation d'un GPU afin de réaliser des traitements autres qu'un simple affichage vidéo est appelée en anglais General-Purposed Processing on Graphics Processing Units (GPGPU).

Les 2 constructeurs de cartes graphiques (Nvidia et ATI/AMD) utilisaient chacun leur langage de programmation (CUDA et Stream) jusqu'à ce qu'ils adoptent la norme OpenCL. Dans les implémentations actuelles, il s'agit d'un ensemble de fonctions utilisables en C.

Objectif et plan de travail

L'objectif de ce TER est de d'étudier et de développer une chaîne de traitement basée sur des outils open-source permettant la parallélisation automatique d'une application afin d'exploiter la puissance de calcul d'une carte graphique. Cette étude visera à améliorer les performances de logiciels de tailles et de complexités différentes.

Encadrant : M. David JANISZEK

Email : david.janiszek at parisdescartes.fr

N° du Sujet: P2

Contexte de l'étude

Mettre en œuvre une interface entre une plate-forme VoIP basée sur le logiciel open-source Asterix et un système de reconnaissance de la parole dans le cloud et étudier son impact en termes de performances et d'ergonomie.

Objectif et plan de travail

Les technologies VoIP et VoiceXML sont entrées dans des phases de maturité, et leurs qualités leur ont permis d'être largement adoptées. Ainsi les applications directement issues des premières phases du développement de ces technologies ont données naissance à de nouvelles possibilités et de nouveaux besoins.

Le but de ce TER est de mettre en œuvre un démonstrateur de serveur vocal interactif, basé sur les technologies VoiceXML, VoIP et de virtualisation afin de faciliter le déploiement de ce démonstrateur.

Dans un premier temps, il faudra réaliser une étude détaillée des solutions offertes par les logiciels libres permettant d'interfacer un système de reconnaissance de la parole à un réseau VoIP.

Dans un deuxième temps, à partir de l'étude précédemment menée, une mise en œuvre de la solution préconisée devra être réalisée afin d'interfacer le serveur vocal interactif et un service basé dans le cloud. Cette solution devra pouvoir être mise en œuvre sur un serveur virtualisé. Enfin, dans un troisième temps, on réalisera une démonstration d'annuaire téléphonique.

Références

[1] Speech Processing for IP Networks - Auteur: Burke - Editeur: Wiley - 2007

[2] Asterisk - Auteur: Van Meggelen - Editeur : O’Reilly – 2008

Encadrant : M. David JANISZEK

Email : david.janiszek at parisdescartes.fr

N° du Sujet: P3

Contexte de l'étude

Avec la multiplication des documents numériques, il devient rapidement nécessaire de proposer un moteur de recherche pour en faciliter l'exploitation. Une des fonctionnalités d'un moteur de recherche, est la recherche de documents traitant du même thème.

Objectif et plan de travail

L'objectif de ce TER est le développement d'un moteur de recherche de documents analogues et leur représentation sous forme de cartes heuristiques. Il s'agit de développer un outil qui identifie un ensemble de documents dont le thème principal est identique à celui d'un document de référence.

L'ensemble de données (le corpus) utilisé sera l'encyclopédie collaborative Wikipédia. Dans ce cadre, on assimilera un article à un document. Comme dans tout wiki, les différents articles qui la composent sont regroupés en espaces de noms que l'on peut assimiler à des thèmes. Ainsi, son organisation en thèmes permet d'envisager un certain type de vérification des algorithmes qui seront implémentés

Il est possible de télécharger l'intégralité de Wikipédia en récupérant les fichiers de sauvegarde : les dumps. Les dumps, sont des fichiers au format XML qui contiennent l'ensemble des informations liées à chaque article : son contenu, son historique, son espace de noms, les discussions liées, etc. Malheureusement, les outils actuellement disponibles sont inefficaces voire inefficients pour traiter la structure des fichiers XML adoptée par Mediawiki (le moteur wiki utilisé par Wikipédia). Aussi, ils ne permettent pas une exploitation aisée des contenus des dumps.

Dans un premier temps, il faudra étudier, de manière détaillée, la structure des dumps de

Wikipédia. Puis, afin de permettre l'exploitation des données contenues dans les dumps, il sera probablement nécessaire de développer une chaîne de traitement. Ensuite, le développement du moteur de recherche, nécessitera l'implémentation d'un algorithme de recherche dont on évaluera la pertinence. Enfin, on affichera les résultats de la recherche sous forme de carte heuristique.

Références

[1] http://fr.wikipedia.org/wiki/Wikipédia:Télécharger_la_base_de_données

[2] http://fr.wikipedia.org/wiki/TF-IDF

Encadrant : M. Damien PELLIER

Email : damien.pellier at mi.parisdescartes.fr

N° du Sujet: I4

Présentation

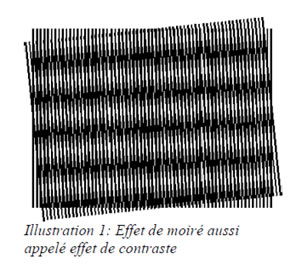

Le moiré est un effet de contraste changeant avec la déformation d'un objet, indépendamment des effets d'ombre (cf. image ci-dessous). Le nom vient du mot arabe mohair. On parle souvent du moiré d'une étoffe (par exemple de la soie). On peut obtenir un effet similaire en superposant deux voiles à maille régulière, ou bien lorsque l'on observe deux grillages l'un derrière l'autre, ou encore deux rambardes de pont, à une certaine distance.

D'une manière générale, le moiré est une figure composée de lignes sombres et claires résultant de la superposition de deux réseaux (ensemble de lignes globalement parallèles). Il s'agit en fait d'un phénomène d'interférences spatiales entre les deux réseaux. Ce phénomène peut être utilisé pour analyser la déformation d'un objet ; il permet aussi d'expliquer le phénomène de tramage que l'on a lorsque l'on numérise (« scanne ») une image composée de points (comme une photo de quotidien), ou bien l'effet étrange produit par une chemise à rayures à la télévision (superposition de la trame de la chemise et de la trame de l'écran).

L'objectif de ce TER est d'utiliser les effets de contraste que peut percevoir un robot via ses caméras. Dans ce cadre, on utilisera le robot NAO pour lui permettre de se localiser dans une pièce. Le problème de la localisation est un problème central en robotique. Pour de nombreuses tâches, les robots doivent être capables de se localiser pour exécuter des tâches extrêmement précises, e.g. prendre un objet, fermer une porte, etc.

Ce stage aborde les problématiques de la perception en robotique et nécessite que vous soyez intéressés par les aspects techniques liés au traitement d'image. Un bon niveau en programmation C++, C, ou Java est nécessaire.

Le travail à réaliser

Vous devrez développer un programme permettant au robot de se localiser dans une pièce. Une vidéo de démonstration devra présenter vos résultats.

Informations diverses

Le TER peut se poursuivre par un stage rémunéré au cours de l'été.

Encadrant : Mme Marie-José CARATY

Email : Marie-Jose.caraty at parisdescartes.fr

N° du Sujet: P4

Contexte de l'étude

La voix véhicule de nombreuses informations de nature linguistique (message, prosodie, …), paralinguistique (stress, émotion, pathologie physique ou mentale, …) et extralinguistique (conventions, contexte, …). Le but de cette étude est d'étudier un bio-marqueur vocal [1] de la schizophrénie. Il s'agit d'un ensemble d’affections mentales aboutissant à une désorganisation profonde de la personnalité. Cette désorganisation se caractérise dans la voix des malades par une atonie dans les échanges verbaux, un appauvrissement du discours et des difficultés de prononciation.

Objectif et plan de travail

Le sujet du TER est le développement d'un bio-marqueur vocal basé sur des méthodes avancées de recherche de motifs comme les arbres de suffixes [2]. Le programme INTSINT [3] permet de représenter la parole par une suite de symboles représentatifs de l'évolution de l'intonation. Le corpus utilisé provient de patients atteints de schizophrénie et de témoins [4].

Références

[1] Viliam Rapcan, Shona D’Arcy, Sherlyn Yeap, Natasha Afzal, Richard B. Reilly. Acoustic and temporal analysis of speech: A potential biomarker for schizophrenia, Medical Engineering and Physics 32 (2010).

[2] Esko Ukkonen, « On-line construction of suffix trees », dans Algorithmica, vol. 14, no 3, 1995, p. 249—260

[3] Hirst, D.J 2007. A Praat plugin for MOMEL and INTSINT with improved algorithms for modelling and coding information, ICPhS.

[4] Lagodka A., (2009), Etude ATOM : Peut-on prédire l’altération du fonctionnement social chez le sujet âgé atteint de schizophrénie par un déficit en Théorie de l’Esprit, Mémoire M2 CogMaster, Centre de Psychiatrie & Neurosciences, Hôpital Saint Anne.

Encadrant : Mme Marie-José CARATY

Email : Marie-Jose.caraty at parisdescartes.fr

N° du Sujet: P5

Contexte de l'étude

La veille informationnelle sur les contenus du web reliés à un secteur d'activité (web d'entreprise, associations professionnelles, salons et expositions, articles de journaux, offres d'emploi et de stage, ....) est devenu un outil indispensable pour tous les professionnels de ce secteur. Des normes ont été définies (flux RSS, Atom) [1] pour suivre les mises à jour de ces contenus. Une des solutions utilisées pour rendre possible cette veille est d'agréger ces contenus sur un portail unique.

Objectif et plan de travail

Le sujet du TER est le développement d'un portail sur le secteur d'activité du plurimédia agrégeant les flux RSS des différents entreprises de ce secteur [2], de l'Apec et des portails de stage. La première partie de l'étude consistera à développer ou à réutiliser un agrégateur [3, 4] dans un langage de votre choix (php, python, java, ...). La deuxième partie sera l'étude des flux RSS disponibles et de leur filtrage. Enfin, ces flux seront agrégés et visualisés sur une page web.

Références

[1] HeinzWittenbrik, RSS 1.x et 2.0 et Atom : Fils et syndication, Eyrolles, 2006

[2] Marie-José Caraty & Claude Montacié. Découverte de la spécialité professionnelle Ingénierie Informatique du Plurimédia, Université Paris Descartes, 2012.

[3] http://sourceforge.net/projects/rssreaderwajax/

[4] http://sourceforge.net/projects/rssowl

Encadrant : M. Norbert COT

Email : norbert.cot at math-info.univ-paris5.fr

N° du Sujet: IA1

Présentation

Le binôme devra :

Encadrant : M. Norbert COT

Email : norbert.cot at math-info.univ-paris5.fr

N° du Sujet: IA2

Présentation

Le binôme devra :

Encadrant : M. Norbert COT

Email : norbert.cot at math-info.univ-paris5.fr

N° du Sujet: IA3

Présentation

Le binôme devra :

Encadrant : M. Norbert COT

Email : norbert.cot at math-info.univ-paris5.fr

N° du Sujet: IA4 et IA5

Présentation

Pour chacune des variantes suivantes de coloriage de graphes, le binôme devra :

Sujet IA4 : Coloriage des sommets de graphes

Sujet IA5 : Coloriage des arêtes de graphes

Encadrant : M. Norbert COT

Email : norbert.cot at math-info.univ-paris5.fr

N° du Sujet: IA6 et IA7

Présentation

Fondamentalement, deux projets peuvent être développés concernant le Sudoku :

Sujet IA6 : Programmation du Sudoku. Le binôme devra :

Sujet IA7 : Analyse du Sudoku- Le nombre de Dieu du Sudoku :

Plusieurs questions théoriques se posent à ce sujet. L’une d’elles concerne le nombre minimal d’indices initiaux pour lequel le Sudoku présente une solution unique (Ce nombre est appelé le nombre de Dieu du Sudoku). Or cette question vient semble-t-il d’être résolue ces jours-ci (Gary McGuire, et al). Ainsi, ce 2ième projet a pour but de présenter et d’analyser ce résultat.